В современном мире бизнеса эффективное управление данными является ключевым фактором успеха. Системы управления предприятием (ERP), такие как 1С, и платформы потоковой обработки данных, такие как Kafka, позволяют организациям собирать, хранить и анализировать огромные объёмы информации. В этой статье мы рассмотрим, как выгрузить данные из 1С в Kafka, чтобы обеспечить эффективную аналитику и обработку данных.

1С — это система управления предприятием, которая позволяет автоматизировать бизнес-процессы, вести учёт товаров, финансов, кадров и т. д. Kafka — это распределённая платформа потоковой обработки данных, которая позволяет обрабатывать большие объёмы данных в реальном времени.

Для интеграции 1С и Kafka необходимо настроить процесс выгрузки данных из 1С в Kafka. Это может быть сделано различными способами, в зависимости от требований и возможностей организации.

Интеграция 1С и Kafka позволяет реализовать высокопроизводительные и масштабируемые решения для автоматизации бизнес-процессов. Kafka обеспечивает потоковую передачу данных из 1С в реальном времени, что позволяет оперативно принимать управленческие решения на основе актуальной информации.

Таким образом, интеграция 1С и Apache Kafka представляет собой эффективное решение для оптимизации бизнес-процессов и повышения их эффективности.

Для выгрузки данных из 1С в Kafka потребуются следующие инструменты и компоненты:

- API (Application Programming Interface) — интерфейс программирования приложений, который позволяет взаимодействовать с 1С через программный код.

- Connectors — специальные модули, которые позволяют подключать различные системы к Kafka. Для работы с 1С могут потребоваться специальные connectors.

- Библиотеки для работы с данными — программные библиотеки, которые упрощают работу с данными в 1С и Kafka. Например, можно использовать библиотеки для работы с JSON, XML и другими форматами данных.

Этапы выгрузки данных

1. Подготовка к выгрузке:

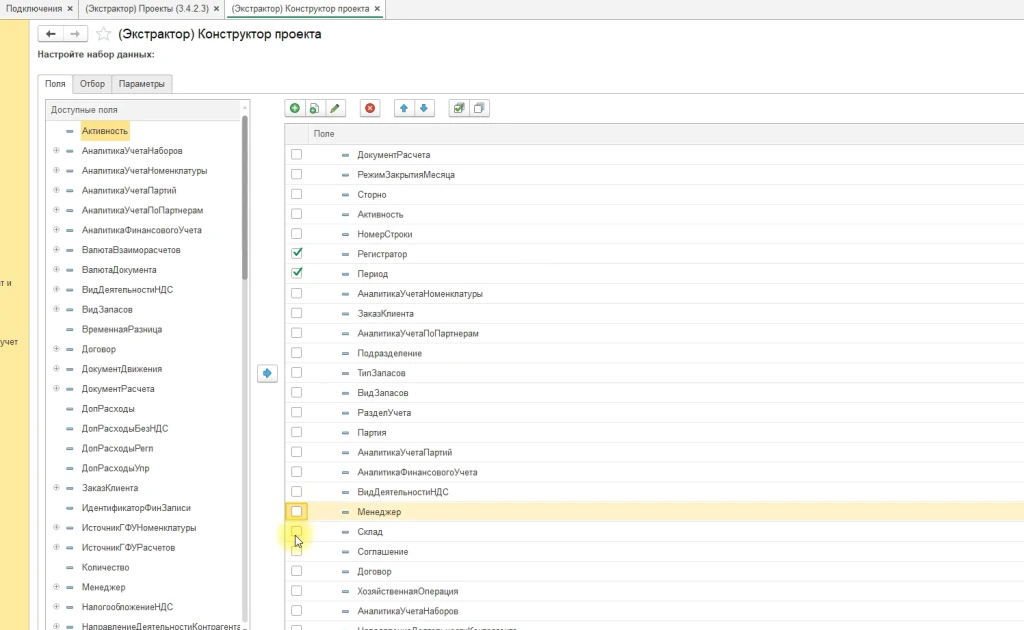

Определение источников и приёмников данных — выбор таблиц и полей в 1С, которые необходимо выгрузить, и определение формата данных в Kafka.

Революция в обработке данных: Apache Kafka и его мощная экосистема

Сегодня мы погрузимся в мир современных технологий обработки данных, а именно в работу с Apache Kafka — платформой, которая стала стандартом для потоковой обработки данных в реальном времени. Мы будем смотреть процесс работы в разрезе множества программ и сервисов, включая наш продукт – Экстрактор 1С.

Первый шаг — установка Kafka. Но не спешите скачивать саму платформу — мы будем работать с REST API, который называется Confluent. Это позволит нам легко интегрировать Kafka в наши проекты.

Шаг 2: Скачивание и настройка Confluent

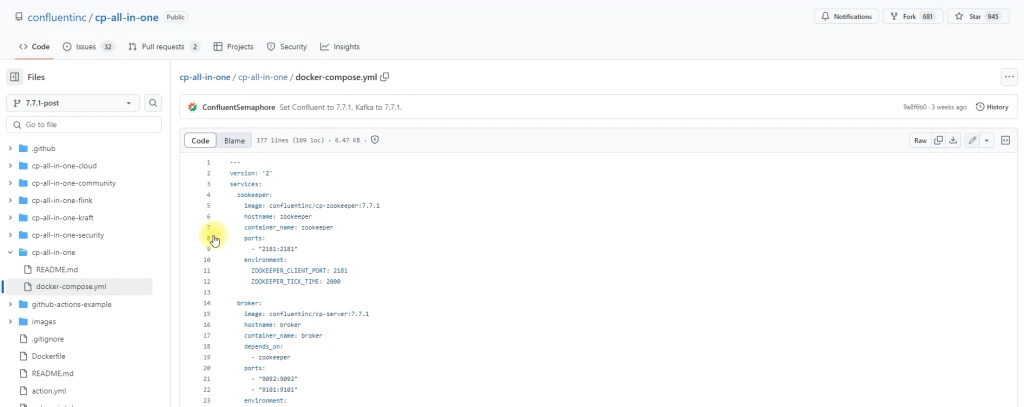

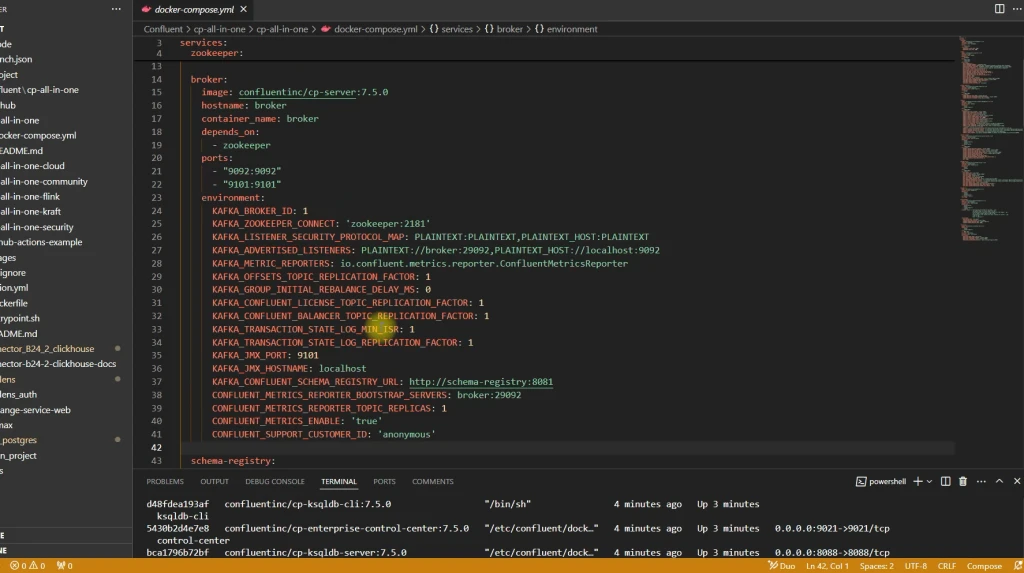

Мы скачали сборку Confluent с файлового репозитория платформы.

Эта сборка включает в себя все необходимые компоненты для работы с Kafka: ZooKeeper, брокер сообщений, Schema Registry и многое другое. Все эти сервисы будут запущены в Docker Compose, что значительно упрощает процесс настройки и управления.

Шаг 3: Запуск Docker Compose

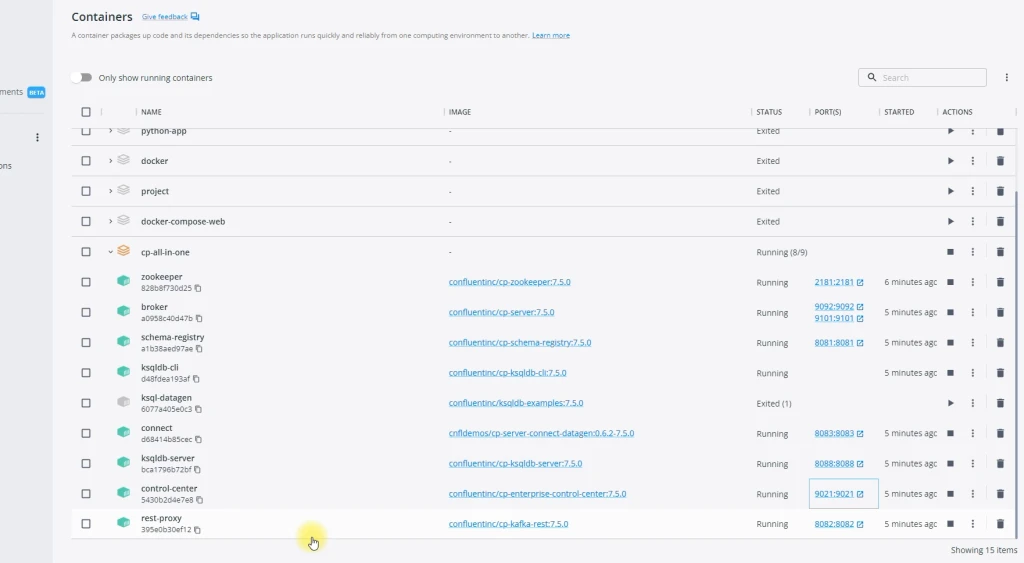

После скачивания файлов запускаем Docker Compose.

В результате появляется контейнер в Docker, в котором работают все необходимые сервисы.

Теперь мы готовы к работе с Apache Kafka!

Apache Kafka — это мощный инструмент, который может значительно улучшить ваши проекты в области обработки данных.

С помощью Confluent вы легко сможете настроить и использовать эту платформу.

- Через API — использование API 1С для получения данных и их последующей передачи в Kafka.

- Через готовые connectors — использование специальных connectors для подключения 1С к Kafka.

- Параметры — определение параметров выгрузки, таких как частота выгрузки, объём данных и т. д.

- Форматы данных — определение формата данных, в котором данные будут передаваться в Kafka (например, JSON, XML).

- Трансформации — преобразование данных из одного формата в другой, если это необходимо.

Возможности Apache Kafka: интеграция с 1С через Control Center

Интеграция 1С с Apache Kafka становится ключевым элементом для достижения максимальной производительности и масштабируемости. Контроль над каждым этапом этого процесса позволит вам эффективно управлять потоками данных.

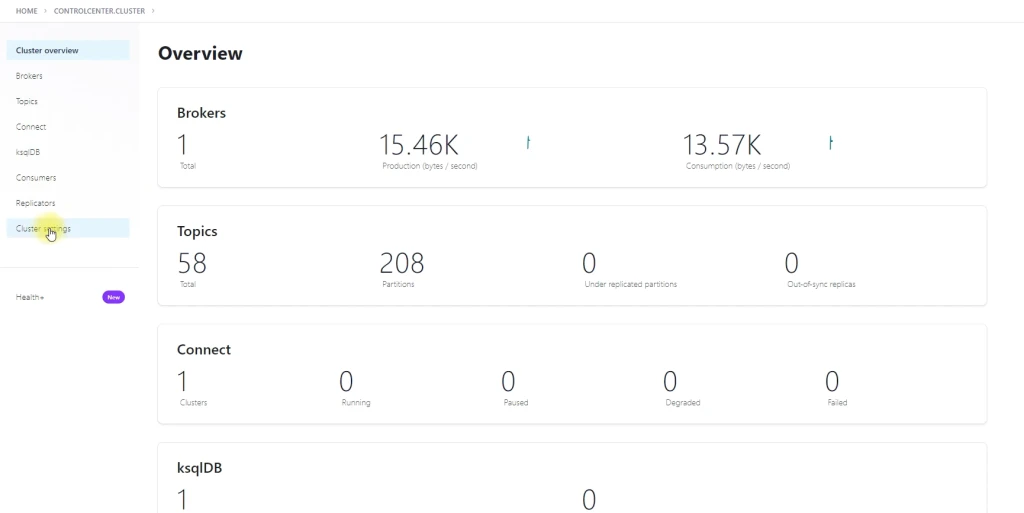

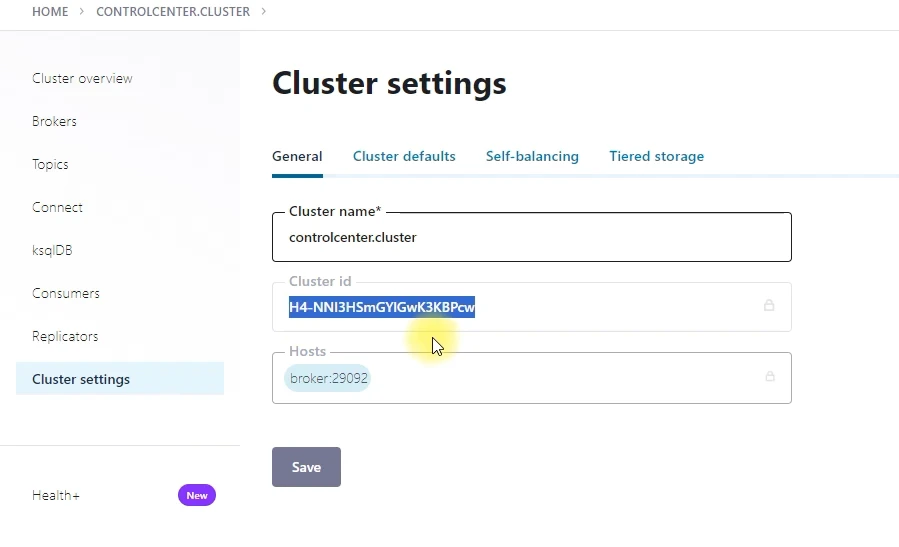

Шаг 1: Открытие Control Center и настройка кластера

Первым шагом является открытие Control Center, где скрыты все необходимые настройки для работы с кластером Kafka.

В настройках кластера необходимо найти идентификатор кластера и скопировать его для дальнейшего использования в подключении экстрактора.

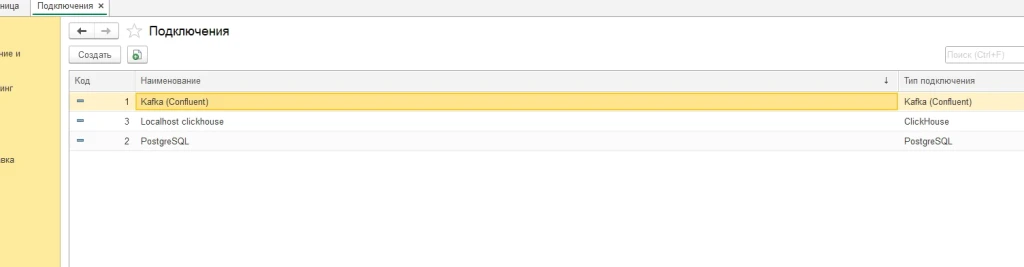

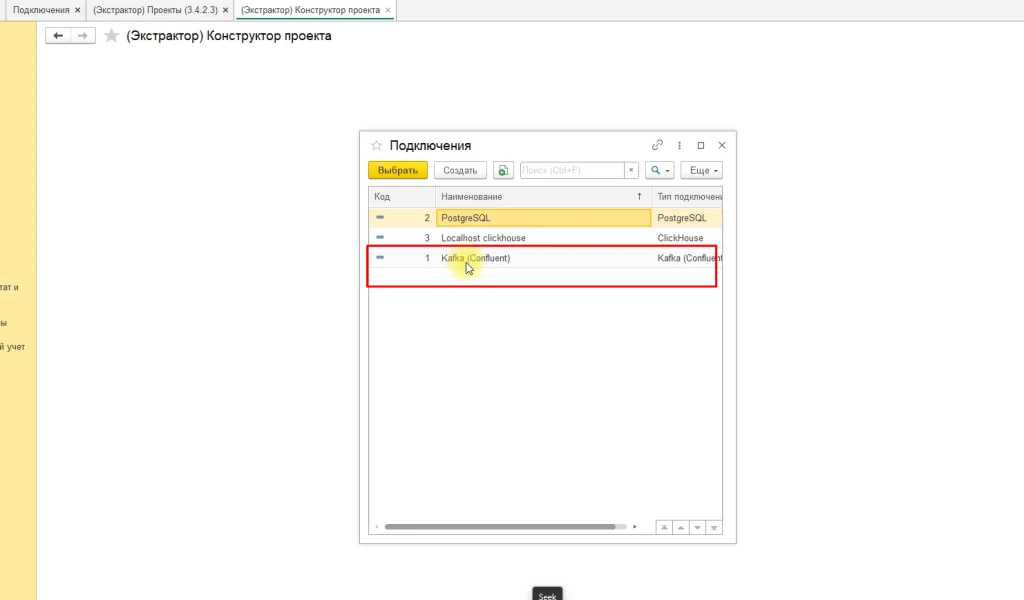

В настройках кластера необходимо найти идентификатор кластера и скопировать его для дальнейшего использования в подключении экстрактора. Шаг 2: Создание нового подключения Экстрактора 1С

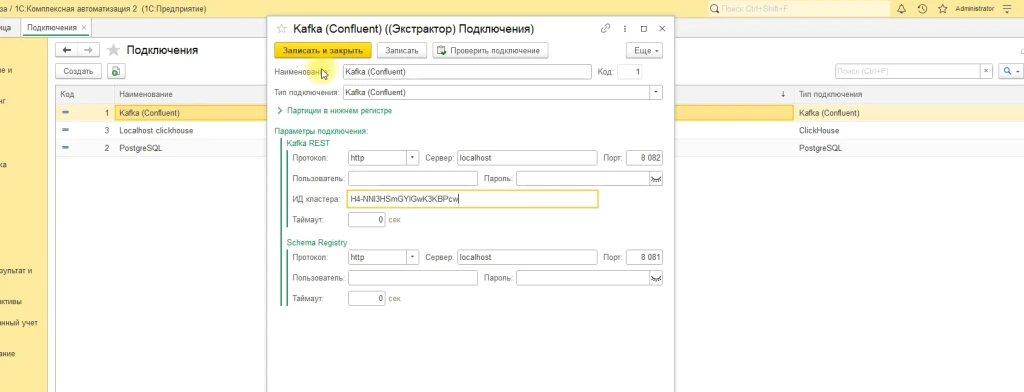

Шаг 2: Создание нового подключения Экстрактора 1С

Далее необходимо создать новое подключение Экстрактора 1С.

В списке типов подключения появится новый элемент — Kafka.

Укажите хост и порт, а также идентификатор кластера и хост и порт Scheme Registry.

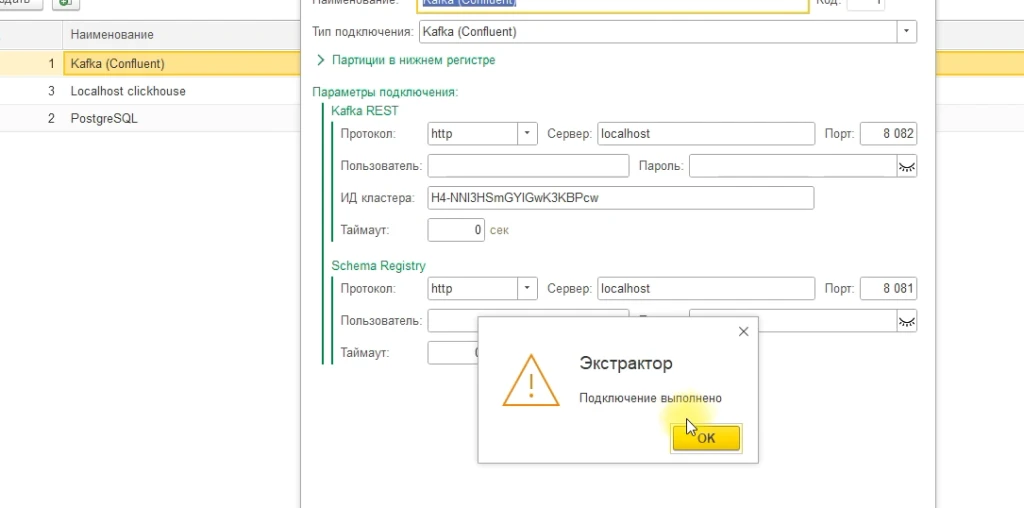

Шаг 3: Проверка и сохранение подключения

После ввода всех необходимых параметров, сохраните подключение и проведите проверку его работоспособности.

Если все выполнено правильно, вы увидите сообщение об успешном подключении.

Если все выполнено правильно, вы увидите сообщение об успешном подключении.

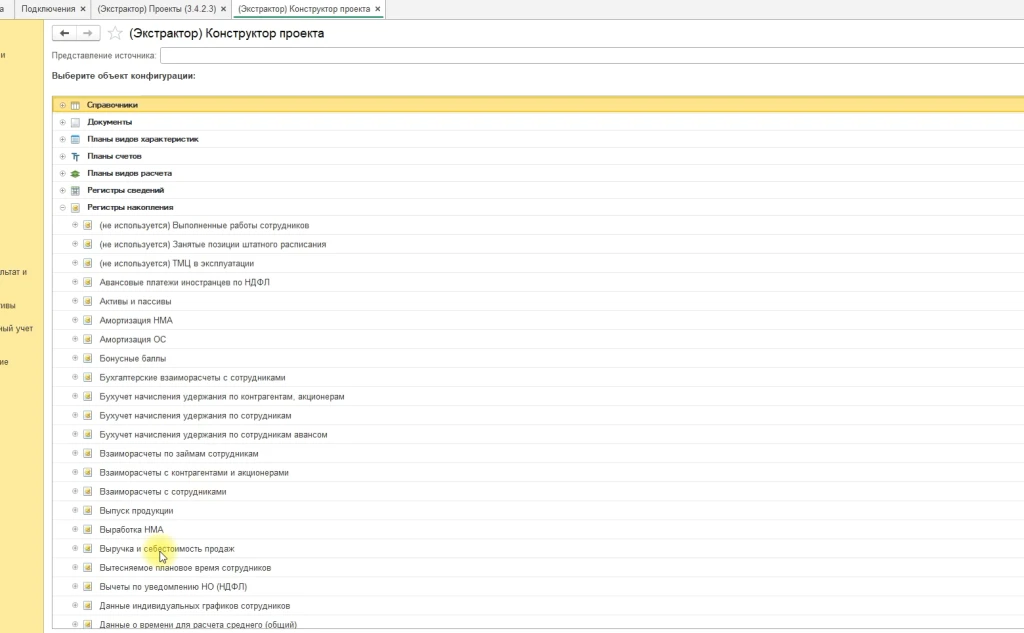

Шаг 4: Начало работы с Apache Kafka

Теперь, когда подключение установлено, вы можете начать работу с Apache Kafka.

Это открывает перед вами новые возможности для анализа данных, построения масштабируемых систем и обеспечения высокой надежности ваших бизнес-процессов.

- Запуск процесса выгрузки — запуск процесса выгрузки данных из 1С в Kafka.

- Мониторинг процесса — отслеживание процесса выгрузки и устранение возможных ошибок.

Погружение в мир потоковой обработки данных

Рассмотрим шаги работы с Kafka и покажем, как с его помощью можно выгрузить данные из вашей системы.

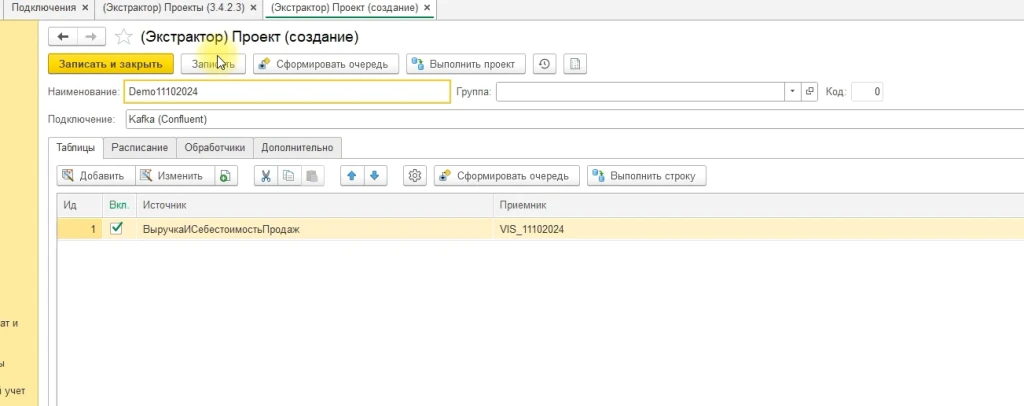

Шаг 1: Создание нового проекта

Первым шагом в нашем путешествии будет создание нового проекта.

Мы не будем брать ничего нового, всё как обычно. Это позволит нам сосредоточиться на ключевых моментах и избежать лишних деталей.

Мы не будем брать ничего нового, всё как обычно. Это позволит нам сосредоточиться на ключевых моментах и избежать лишних деталей.

Шаг 2: Удаление подключения

Перед тем как начать работу с Kafka, необходимо убедиться, что все подключения к вашей системе отключены.

Это важный шаг, который поможет избежать конфликтов и ошибок при работе с данными.

Это важный шаг, который поможет избежать конфликтов и ошибок при работе с данными.

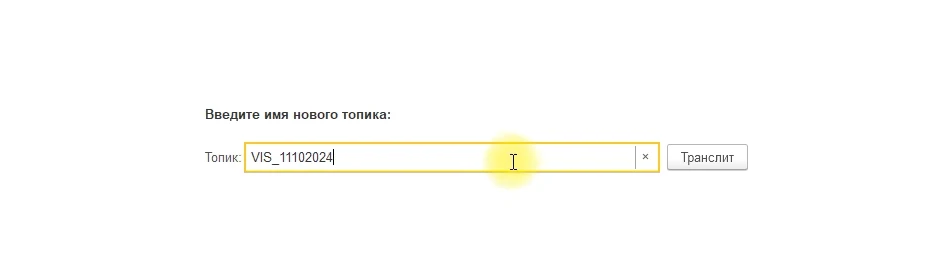

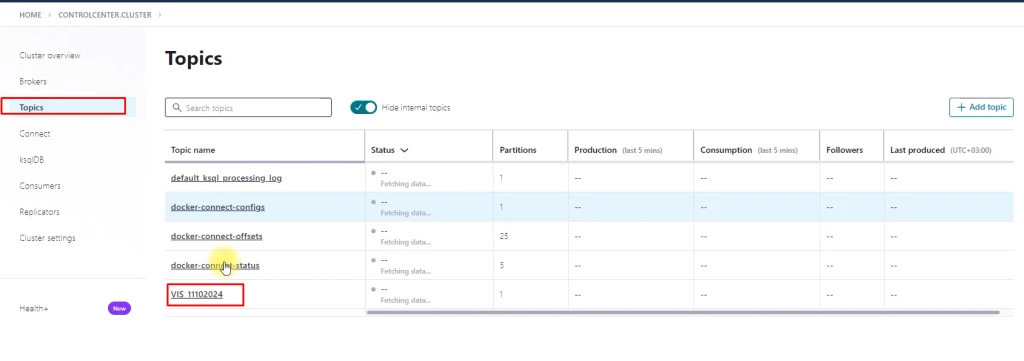

Шаг 3: Создание топика

Теперь, когда все подключения отключены, мы можем создать новый топик в нашем подключении.

Топик — это основной элемент в Kafka, который позволяет хранить и обрабатывать потоки данных.

Топик — это основной элемент в Kafka, который позволяет хранить и обрабатывать потоки данных.

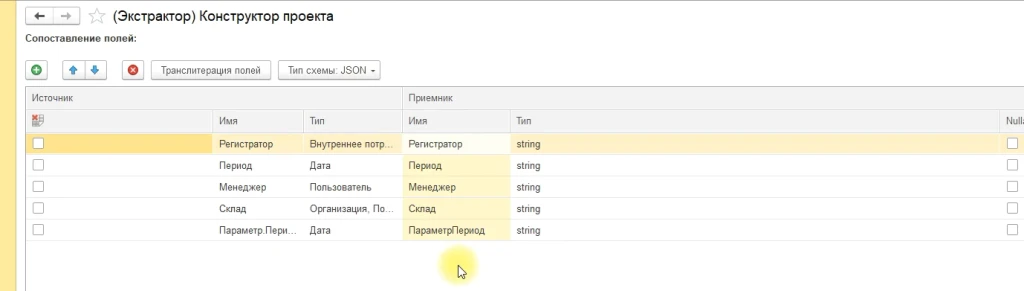

Шаг 4: Настройка формата выгружаемых данных

Одним из ключевых моментов работы с Kafka является настройка формата выгружаемых данных.

В нашем случае мы выберем формат JSON, который является универсальным и легко читаемым.

В нашем случае мы выберем формат JSON, который является универсальным и легко читаемым.

Это позволит нам легко анализировать и использовать полученные данные.

Шаг 5: Завершение настройки

После того как мы выбрали формат данных, необходимо завершить настройку.

Это включает в себя проверку всех параметров и настроек, чтобы убедиться, что всё работает корректно.

Шаг 6: Сохранение проекта

После завершения настройки необходимо сохранить проект.

Это позволит нам вернуться к нему в любой момент и продолжить работу.

Это позволит нам вернуться к нему в любой момент и продолжить работу.

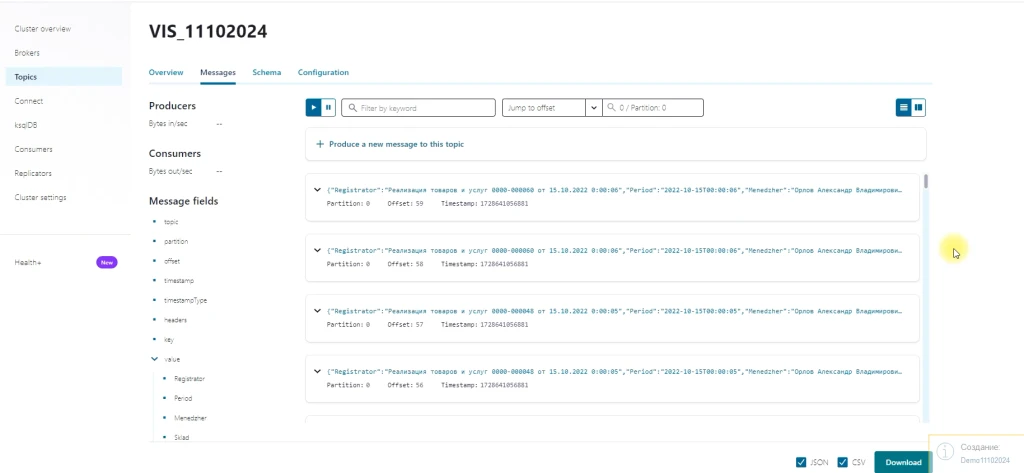

Шаг 7: Тестирование выгрузки данных

Теперь, когда всё настроено, мы можем приступить к тестированию выгрузки данных.

Для этого мы переключимся в контролл-центр и найдём наш топик.

Мы увидим, что схема была создана с описанием метаданных и выгружаемых данных.

Мы увидим, что схема была создана с описанием метаданных и выгружаемых данных.

Шаг 8: Анализ выгруженных данных

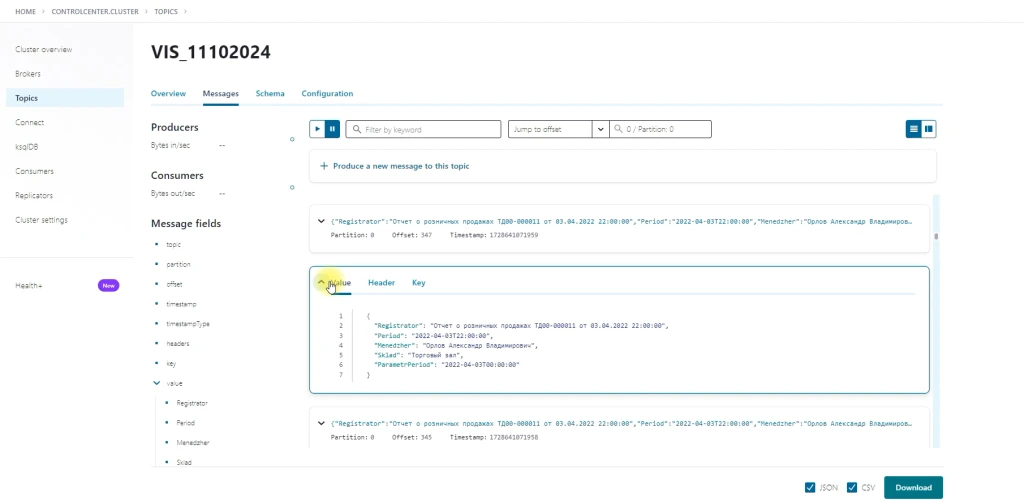

Давайте посмотрим, что у нас получилось.

Мы видим, что данные продолжают поступать, и выгрузка завершена.

В районе трёхсот записей были успешно выгружены.

В районе трёхсот записей были успешно выгружены.

Шаг 9: Визуализация данных

Для удобства анализа мы можем визуализировать полученные данные. В нашем случае набор записей представлен в формате JSON, который легко читается и анализируется.

- Подключение к API 1С — использование программных библиотек для работы с API 1С.

- Настройка параметров выгрузки — определение параметров выгрузки в соответствии с требованиями организации.

- Преобразование данных — использование библиотек для работы с данными для преобразования данных из одного формата в другой.

- Передача данных в Kafka — использование connectors для передачи данных из 1С в Kafka.

Примеры кода или конфигурационных файлов:

Возможные ошибки и способы их устранения:

Ошибки при выгрузке данных могут быть связаны с неправильными настройками, ошибками в коде или проблемами с подключением к API или Kafka. Для устранения ошибок необходимо проверить настройки, код и подключение.

Интеграция с другими системами

- Данные из 1С можно выгрузить в Kafka для дальнейшей обработки и анализа. Например, данные о продажах можно выгрузить в Kafka для анализа трендов и прогнозирования спроса.

- Также данные из Kafka можно передать в системы хранения данных (например, Hadoop) или системы обработки данных (например, Spark).

Примеры использования выгруженных данных:

- Анализ продаж — данные о продажах можно использовать для анализа трендов, прогнозирования спроса и оптимизации ассортимента.

- Управление запасами — данные о запасах можно использовать для оптимизации уровня запасов, снижения издержек и повышения эффективности работы склада.

- Маркетинг — данные о клиентах можно использовать для сегментации аудитории, персонализации маркетинговых кампаний и повышения эффективности маркетинговых расходов.

Безопасность и конфиденциальность:

Меры по обеспечению безопасности данных при выгрузке

Интеграция данных из 1С в Kafka должна соответствовать законодательным требованиям и международным стандартам. Это включает в себя обеспечение конфиденциальности и целостности данных, а также их доступности в соответствии с принципом доступности (Availability). Для этого необходимо регулярно проводить аудит и сертификацию системы, а также внедрять процессы управления инцидентами и рисками.

Примеры практического применения интеграции системы 1С с платформой Kafka

1. Розничная торговля:- Оптимизация складских операций. Интеграция 1С с Kafka позволяет в реальном времени передавать данные о продажах и остатках товаров на складе. Это обеспечивает более точное планирование закупок и оптимизацию складских запасов. Например, при снижении остатков ниже определённого уровня система может автоматически формировать заказ поставщику.

- Анализ продаж. Платформа Kafka может передавать данные о продажах в систему 1С для дальнейшего анализа. Это позволяет выявлять тенденции, анализировать эффективность маркетинговых кампаний и принимать обоснованные решения по ценообразованию.

- Интеграция с системами лояльности. Данные о покупках клиентов могут передаваться в систему 1С для управления программами лояльности. Это позволяет персонализировать предложения и повысить удовлетворённость клиентов.

- Отслеживание грузов. Интеграция 1С с Kafka позволяет отслеживать перемещение грузов в реальном времени. Данные о местоположении транспортных средств и грузов могут передаваться в систему 1С для мониторинга и управления логистическими процессами.

- Оптимизация маршрутов. Система может анализировать данные о трафике, погодных условиях и других факторах для оптимизации маршрутов доставки. Это снижает время доставки и затраты на топливо.

- Управление транспортными средствами. Данные о состоянии транспортных средств (например, уровень топлива, температура в рефрижераторах) могут передаваться в систему 1С для мониторинга и управления парком транспортных средств.

- Управление производственными процессами. Интеграция 1С с Kafka позволяет оптимизировать производственные процессы, передавая данные о состоянии оборудования, запасах материалов и других параметрах. Это обеспечивает более эффективное планирование производства и снижение простоев.

- Мониторинг качества. Данные о качестве продукции могут передаваться в систему 1С для контроля и управления процессами контроля качества. Это позволяет своевременно выявлять и устранять проблемы, повышая качество продукции.

- Планирование технического обслуживания. Данные о состоянии оборудования могут использоваться для планирования технического обслуживания. Это снижает риски простоев и повышает надёжность производства.

- Обработка транзакций. Интеграция 1С с Kafka позволяет оптимизировать обработку финансовых транзакций, передавая данные в реальном времени. Это сокращает время обработки платежей и повышает эффективность работы банков.

- Мониторинг финансовых показателей. Данные о финансовых показателях (например, оборотные средства, прибыль) могут передаваться в систему 1С для мониторинга и анализа. Это позволяет своевременно выявлять проблемы и принимать обоснованные управленческие решения.

- Управление рисками. Данные о кредитных историях клиентов и других факторах могут передаваться в систему 1С для оценки рисков и принятия решений о выдаче кредитов.

Для интеграции 1С с Kafka можно использовать различные технологии и инструменты. Например, для работы с Kafka можно использовать язык программирования Java или Python.

Пример кода на Java для подключения к Kafka и отправки сообщения:

Статистикаimport org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

public class KafkaProducerExample {

public static void main(String[] args) {

// Настройка свойств производителя

Properties properties = new Properties();

properties.put("bootstrap.servers", "localhost:9092");

properties.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

properties.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// Создание производителя

KafkaProducer<String, String> producer = new KafkaProducer(properties);

// Отправка сообщения

ProducerRecord<String, String> record = new ProducerRecord("topic", "message");

producer.send(record);

// Закрытие производителя

producer.close();

}

}

- Сокращение времени отклика информационных систем: внедрение интеграции 1С и Kafka позволяет сократить время отклика информационных систем на 30–50%.

- Повышение надёжности и целостности данных: интеграция обеспечивает более надёжную передачу данных между системами, что снижает риск потери или искажения информации.

- Оптимизация процессов аналитики и принятия управленческих решений: интеграция позволяет более эффективно анализировать данные и принимать обоснованные управленческие решения, что повышает операционную эффективность предприятий.

Внедрение системы выгрузки данных из 1С в Kafka может привести к следующим преимуществам:

-

Повышение эффективности бизнес-процессов — оптимизация ассортимента, снижение издержек, повышение эффективности работы склада и т. д.

-

Улучшение качества данных — обеспечение точности и актуальности данных для принятия обоснованных решений.

Снижение затрат — оптимизация использования ресурсов и снижение издержек на обработку данных.